Des jugements faussés par l’IA

Il arrive parfois que des avocats soient pointés pour avoir utilisé une intelligence artificielle (IA) sans vérifier suffisamment les résultats.

Il est plus rare que des juges admettent que leurs décisions ont été entachées par leur propre utilisation de l’IA.

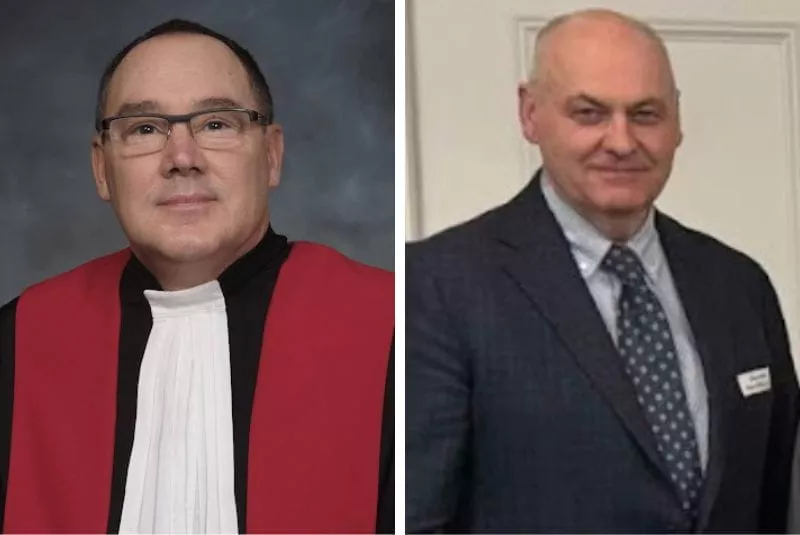

C'est pourtant ce qu'on reconnu deux juges fédéraux, Henry Wingate du district sud du Mississippi et Julien Neals du district du New Jersey.

Les deux juges ont émis des ordonnances rédigées par leur personnel, qui « citaient de manière erronée le droit de l'État, faisaient référence à des individus qui n'apparaissaient pas dans l'affaire, et attribuaient de fausses citations aux défendeurs, entre autres inexactitudes importantes », rapporte Reuters.

Les ordonnances ont ensuite été révoquées et remplacées par des versions correctes.

Les juges ont chacun déclaré avoir pris des mesures pour s'assurer que de telles erreurs ne se reproduisent pas.

Ces deux cas ont été dévoilés par Chuck Grassley, le sénateur républicain de l’Iowa, qui dit avoir félicité les deux juges d'avoir reconnu leurs erreurs.

Le juge Henry Wingate a expliqué que l'ordonnance initialement publiée était un brouillon qui n'avait pas été soumis au processus de révision standard. L'ordonnance portait sur la limitation de l'entrée en vigueur des pratiques de diversité équité inclusion (DEI).

Pour sa part, le juge Julien Neals a expliqué que, dans son équipe, un stagiaire en droit a utilisé ChatGPT pour effectuer des recherches juridiques, sans autorisation, sans divulgation, contrairement à la politique de son cabinet, et à la politique de l'école de droit.

Le juge Neals s'est depuis assuré que sa politique est désormais communiquée de manière écrite, plutôt que verbalement.

L'ordonnance du juge Neals rejetait une demande de la société CorMedix, qui entendait rejeter un procès intenté par des actionnaires.

Partager cet article:

Gmail

Gmail

Outlook

Outlook